Robots.txt é uma norma utilizada no desenvolvimento Web que serve de orientação para os robots da Web, normalmente motor de busca[2] crawlers, navegando num sítio Web[4]. Proposto por Martijn Koster em 1994, funciona como uma ferramenta de comunicação, pedindo aos robôs que evitem determinados ficheiros ou secções do sítio Web. Este ficheiro é colocado na raiz de um sítio Web e é particularmente importante para otimização de motores de busca[1] (SEO), uma vez que ajuda a controlar as partes do sítio que são indexadas. Embora não exista um mecanismo de aplicação legal ou técnica, a conformidade com esta norma é crucial para um rastreio eficiente e seguro do sítio Web. É de salientar que a norma tem evoluído ao longo do tempo, com actualizações que reflectem as alterações webmaster[3] e que compreender as suas nuances é imperativo para uma SEO eficaz.

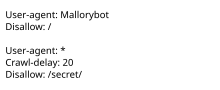

robots.txt é o nome de ficheiro utilizado para implementar o Protocolo de exclusão de robôs, uma norma utilizada por sítios Web para indicar aos visitantes rastreadores da web e outros robôs da web que partes do sítio Web estão autorizadas a visitar.

A norma, desenvolvida em 1994, baseia-se em cumprimento voluntário. Os bots maliciosos podem utilizar o ficheiro como um diretório das páginas a visitar, embora os organismos de normalização desencorajem a utilização de segurança através da obscuridade. Alguns sítios de arquivo ignoram o robots.txt. A norma foi utilizada na década de 1990 para mitigar servidor sobrecarga; na década de 2020, muitos sítios Web começaram a recusar bots que recolhem informações para inteligência artificial generativa.

O ficheiro "robots.txt" pode ser utilizado em conjunto com mapas de sítiosoutra norma de inclusão de robôs para sítios Web.