Robots.txt est une norme utilisée dans le développement web qui sert de ligne directrice pour les robots web, habituellement moteur de recherche[2] crawlers, naviguer dans un site web[4]. Proposé par Martijn Koster en 1994, il fonctionne comme un outil de communication, demandant aux robots d'éviter des fichiers ou des sections spécifiques du site web. Ce fichier est placé à la racine d'un site web et est particulièrement important pour optimisation des moteurs de recherche[1] (SEO), car elle permet de contrôler les parties du site qui sont indexées. Bien qu'il n'existe pas de mécanisme d'application juridique ou technique, le respect de cette norme est essentiel pour une exploration efficace et sûre des sites web. Il convient de noter que la norme a évolué au fil du temps, les mises à jour reflétant l'évolution de l'indexation des sites web. webmaster[3] et qu'il est impératif d'en comprendre les nuances pour un référencement efficace.

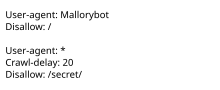

robots.txt est le nom de fichier utilisé pour la mise en œuvre de la Protocole d'exclusion des robotsune norme utilisée par les sites web indiquer à la visite robots d'indexation et autres robots web les parties du site qu'ils sont autorisés à visiter.

La norme, élaborée en 1994, repose sur les éléments suivants conformité volontaire. Les robots malveillants peuvent utiliser le fichier comme un répertoire des pages à visiter, bien que les organismes de normalisation déconseillent de contrer cela avec des la sécurité par l'obscurité. Certains sites d'archives ignorent robots.txt. La norme a été utilisée dans les années 1990 pour atténuer l'impact des robots. serveur surcharge ; dans les années 2020, de nombreux sites web ont commencé à refuser les robots qui collectent des informations pour le compte de la Commission européenne. intelligence artificielle générative.

Le fichier "robots.txt" peut être utilisé en conjonction avec le fichier sitemapsune autre norme d'inclusion de robots pour les sites web.